«У нас реализуется принцип многокомпонентной защиты». CDO Kaspi рассказал, как в банке противостоят дипфейкам

Думан Уватаев

С развитием технологий в мире расширяется и инструментарий для мошенников. Так, к примеру, в начале года всех поразила история, как сотрудники гонконгского филиала одной международной компании по поручению CFO, который присутствовал на видеозвонке, перевели $25 млн на определенный счет. Позже выяснилось, что видеоряд с финансовым директором и несколькими его коллегами оказался дипфейком, сгенерированным искусственным интеллектом.

Сегодня, отмечает CDO Kaspi.kz Думан Уватаев, дипфейки используются в первую очередь для атак на организации, связанные с финансовым сектором. Естественно, особое внимание злоумышленники уделяют банкам. На конференции Kolesa Conf эксперт рассказал, какие есть виды дипфейков, с помощью чего они создаются и каким образом им противостоят в Kaspi.kz. Digital Business приводит главные тезисы из выступления Думана.

«Количество атак с применением дипфейков возросло в десятки раз»

– Kaspi.kz – одно из самых популярных приложений в Казахстане, которым пользуются свыше 14 млн человек. Однако перед тем, как человек оформит новый продукт, подключит сервис или подпишет документ, мы должны удостовериться, что услугу запрашивает действительно наш клиент. С начала года в приложении Kaspi.kz прошло более 160 млн сессий биометрической фотоверификации. Это делается для того, чтобы максимально обезопасить данные наших клиентов.

Дипфейки – серьезный вызов, с которым мы сталкиваемся. На рынке уже хватает разных решений, способных воссоздать лицо атакуемого человека так, что дипфейк будет похож на него больше, чем он сам. При этом количество атак с применением такой технологии возросло в десятки раз. И по прогнозам разных международных компаний их число будет только расти.

Для атак в основном используются следующие виды дипфейков:

Face Swap – позволяет переносить лицо одного человека на фото или видео вместо лица другого. Причем замена выглядит довольно естественно.

Face Reenactment – занимается синтезом лица, когда с помощью разных картинок можно оживлять изображение того или иного человека.

Lip-sync – подразумевает согласование движений губ людей или персонажей анимации со звуковым содержанием, таким как речь, песни или музыка.

Face synthesis – может генерировать реалистичные и разнообразные изображения лиц с нуля или на основе некоторых данных.

Для создания дипфейков используют разные ИИ-модели. Например, GAN (генеративно-состязательные нейронные сети – прим. Digital Business), которые работают на комбинации двух нейросетей. Первая – генератор, который создает новые данные, похожие на исходные. Вторая – дискриминатор, который оценивает эти данные и пытается определить, реальные они или сгенерированные. Простым языком, создается состязательный процесс, где генератор пытается обмануть дискриминатор – в этом и заключается принцип обучения.

Еще есть DeepFuse – такая нейросеть использует исходное фото или видео, где заменяет большую часть изображения на белый шум, а потом восстанавливает его с требуемым лицом в зависимости от заданных параметров. В результате получаетсяР качественное изображение, на котором сложно определить, настоящее оно или сгенерированное. На данный момент DeepFuse – один из самых продвинутых методов для генерации дипфейков.

«Чтобы бороться с дипфейками, необходимо иметь ИИ-модель в противовес, а желательно их комбинацию»

– Распознать некоторые дипфейки можно и невооруженным взглядом. Например, на них могут быть разные дефекты: неестественно гладкая кожа, отсутствие морщин, родинок или несовпадение прически. Однако только на это рассчитывать не стоит.

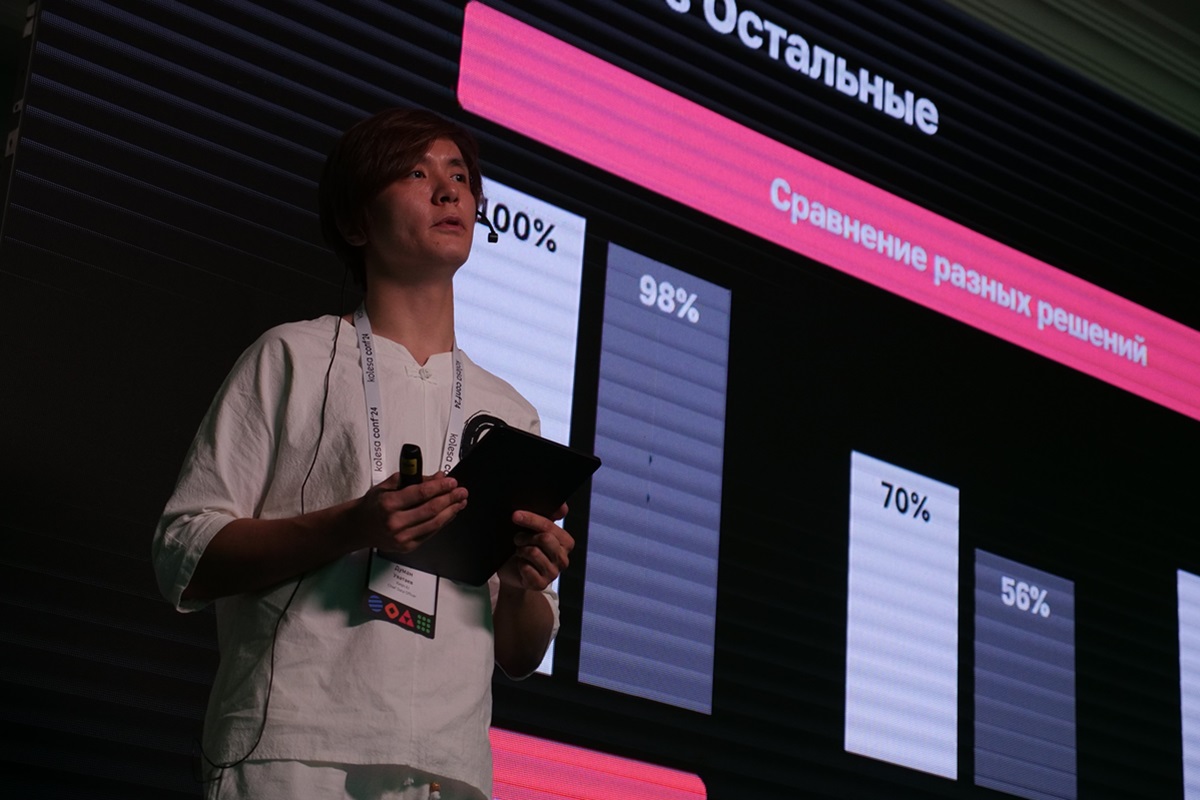

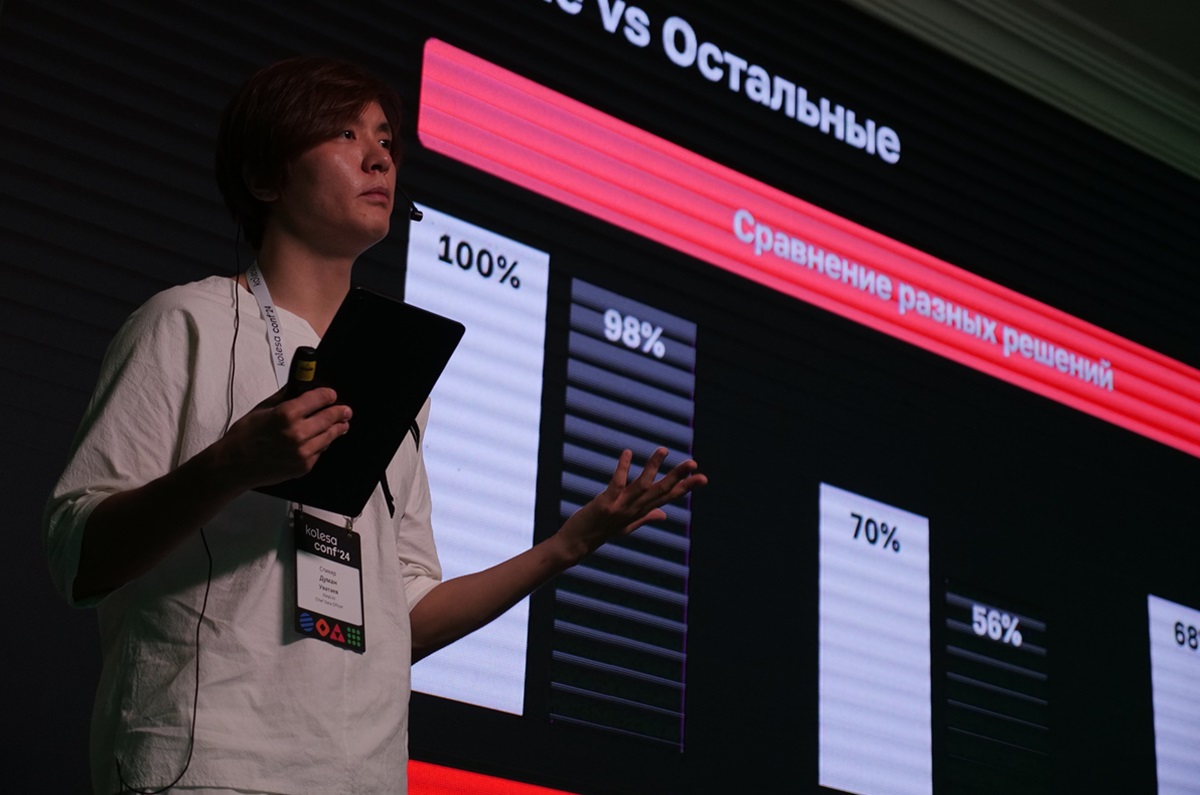

Чтобы бороться с дипфейками, необходимо иметь ИИ-модели в противовес, а желательно их комбинацию. Мы в Kaspi для этого используем широкий арсенал нейросетей. Выбор конкретной архитектуры зависит от типа данных, уровня сложности подделки и требуемой точности обнаружения. К последнему пункту у нас довольно высокие требования. В теории при прохождении фотоверификации мы могли бы отказывать каждому второму пользователю в получении доступа, но при этом быть на 100% уверенными, что не пропустим мошенников. Однако в таком случае страдают клиенты. По этой причине сразу отказались от покупки пакетных решений и занялись разработкой собственного, чтобы не доставлять нашим пользователям дискомфорт, и при этом обеспечивать высокий уровень безопасности.

Как я уже говорил, для выявления дипфейков используем в связке несколько типов нейросетей. Среди них есть, например, сверточные (специализируются на обработке изображений– прим. Digital Business), которые хорошо справляются с анализом фото и видео, где пытаются найти разного рода артефакты, возникающие при создании дипфейков.

Еще есть рекуррентные нейросети (разработаны для обработки и анализа последовательных данных – прим. Digital Business), которые способны сохранять информацию о предыдущих шагах обработки, что позволяет учитывать контекст и временные зависимости. Также используем и другие ИИ-модели.

В конечном итоге получается громадная солянка из ряда технологий, где у каждой ИИ-модели есть определенная цель. Например, одни анализируют конкретное изображение (статичный подход), а другие – совокупность изображений (динамичный подход). Таким образом у нас реализуется принцип многокомпонентной защиты. Даже если мошенники дадут нашей системе хорошо сделанный дипфейк, который сможет обмануть одну ИИ-модель, он не пройдет через фильтр другой нейросети.

Данное решение – казахстанский продукт, созданный нашими специалистами, окончившими местные вузы. Хочу сказать, что мы постоянно изучаем новые технологии в этом направлении и пока такой сложной многокомпонентной комбинации не встречали нигде. Очень гордимся, что наши ребята умеют создавать такие уникальные ИТ-решения.

; ?>/10/685a8998-300x200.jpg)

; ?>/02/microsoftteams-image-64.png)